Visualiser ce que nous écoutons pour comprendre les sons de parole from Ça Fait Science on Vimeo.

Découvrez la recherche psycholinguistique à travers une question simple : quels sont les processus cognitifs nous permettant de comprendre les sons de parole de notre interlocut·eur·rice ? L’équipe de Léo Varnet nous a ouvert les portes du laboratoire des Systèmes Perceptifs à l’ENS pour nous expliquer leur approche psychophysique dans ce 3ème épisode de Qrieux, la série.

Transcription :

Voix off : Lors d’une perte d’audition liée à l’âge, certains sons deviennent inaudibles, ce qui est particulièrement handicapant dans un environnement bruyant comme un repas de famille. L’utilisation d’audioprothèses permet l’amplification des sons atténués pour les rendre à nouveau audibles. L’audioprothèse amplifie les bruits ambiants en même temps que les sons de parole ce qui empêche une bonne compréhension. Notre cerveau a appris à discriminer les sons utiles des bruits gênants ; seulement, les corrections appliquées par l’audioprothèse demandent au cerveau de s’adapter à des sons parasites amplifiés, ce qu’il n’arrive pas toujours à faire. Comment améliorer ces dispositifs et mieux comprendre ce qui empêche les personnes appareillées de retrouver une compréhension normale sont les questions sur lesquelles travaille l’équipe de Léo Varnet, au Laboratoire des Systèmes Perceptifs de l’École Normale Supérieure de Paris.

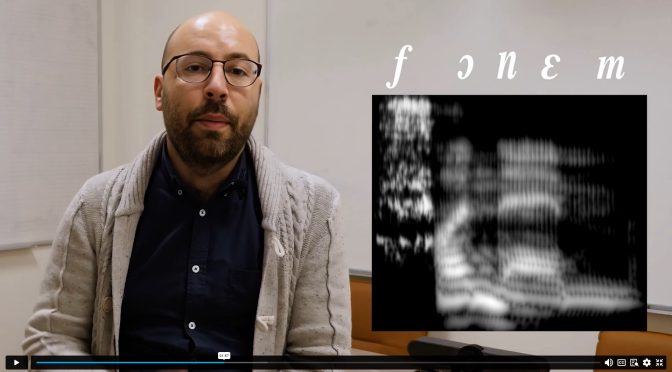

Léo Varnet : Quand on discute avec quelqu’un, pour comprendre ce que cette personne nous dit, pour comprendre les sons qu’elle prononce, il faut d’abord que notre cerveau découpe ces sons en petits éléments successifs qu’on appelle les phonèmes. Ce mot contient en fait 5 phonèmes : \f\ – \ɔ\ – \n\ – \ɛ\ – \m\. Chaque phonème a des caractéristiques sonores particulières : les indices acoustiques. Pour comprendre un son de parole, notre cerveau va analyser en continu et inconsciemment les indices acoustiques que ce son contient. En décodant ces détails très fins du son, notre cerveau va identifier les phonèmes qui ont été prononcés par notre interlocuteur et ensuite recomposer les syllabes, les mots, les phrases et tout le sens du discours. Nous avons mis au point une technique, qu’on appelle l’image de classification auditive, le but va être de visualiser directement les indices acoustiques sur lesquels nous portons notre attention lorsque nous cherchons à comprendre un son parole.

Géraldine Carranante : La technique des Images de Classification Auditive associe une expérience en psychologie cognitive d’un côté avec une méthode d’analyse statistique de l’autre. Dans l’expérience en psychologie cognitive, on va chercher à induire en erreur le participant en lui faisant écouter des phonèmes dans un très fort bruit de fond. La méthode repose sur l’analyse des erreurs de compréhension effectuées par le participant qui sont un reflet du traitement de son cerveau. Plus les indices acoustiques cruciaux à la compréhension des sons de parole vont être masqués par le fort bruit de fond plus le participant va avoir tendance à se tromper. C’est en étudiant ces erreurs qu’on va pouvoir remonter à la connaissance des indices cruciaux à la compréhension des sons de paroles. Concrètement, on place les participants dans une cabine insonorisée et on leur donne comme consigne de différencier deux sons comme « Aba » et « Ada », deux mots qui n’ont pas de sens en français. On leur demande de les différencier dans un très fort bruit de fond. Après avoir entendu chacun des stimulus les participants doivent répondre avec un clavier, s’ils pensent avoir entendu un son ou l’autre. Une fois l’expérience terminée (ce qui correspond à 4000 essais par participant), on effectue une analyse statistique sur les résultats en reliant les réponses du participant et les caractéristiques fines des bruits qu’on a utilisé pour masquer les sons sur chaque essai. Le résultat de cette corrélation, on le montre sous forme d’image, c’est ce qu’on appelle l’Image de Classification Auditive, dans laquelle on peut visualiser les zones du spectre sonore dans lesquelles la présence de bruit a systématiquement induit en erreur le participant. On peut ainsi, mettre en évidence visuellement le ou les indices acoustiques cruciaux pour la compréhension de chaque son de parole.

Alejandro Osses : Une étape cruciale de validation par modélisation est nécessaire pour s’assurer de la pertinence des résultats d’expérience cognitive. Nous avons modélisé le fonctionnement du système auditif humain. Le modèle va alors réaliser les mêmes expériences que les sujets humains en utilisant toutes les informations contenues dans le son, alors que l’humain se concentre seulement sur certains aspects spécifiques du son. La comparaison de ces 2 résultats d’expérience va permettre de préciser les résultats obtenus par les participants humains. Un indice acoustique d’un phonème donné doit être identifié dans les 2 types d’expérience pour être validé.

Léo Varnet : Au cours de ce projet, nous avons développé une nouvelle méthode, qui permet d’identifier, de visualiser où les participants écoutent, c’est-à-dire où ils portent leur attention lorsqu’ils cherchent à comprendre un son de parole. Chaque personne peut développer une stratégie d’écoute particulière en s’appuyant plus sur un indice acoustique ou un autre. Donc sur le long terme, on peut espérer que cette technique amène des avancées considérables dans le domaine de l’audio prothèse. Par exemple, si on parvient à mesurer la stratégie d’écoute individuelle d’une personne, on peut ensuite imaginer ajuster les réglages de l’audioprothèse de cette personne à sa stratégie d’écoute particulière. L’image de classification auditive est une technique qui est à la fois très précise et qui demande peu de moyens pour être mise en œuvre. Il y a encore beaucoup de travail, beaucoup de d’améliorations pour permettre aux spécialistes de l’audition d’utiliser cette méthode en pratique, mais c’est la direction dans laquelle on amène ces recherches.

Crédits

Cette vidéo a été produite par PSL-Qlife et Ça Fait Science

Réalisatrice : Mélanie Durand

Ecriture : Mélanie Durand, Léo Varnet

Régie & Prise de vue et son : Aurdur

Graphisme & Animation : Judith Wahler

Montage et Bruitage : Mélanie Durand

Enregistrement voix off & Mixage : MEL Studio

Voix off : Léa Karpf

Générique : Etienne Boguet

Musique Générique : Guillaume Ballandras

Intervenants scientifiques : Léo Varnet, Géraldine Carranante, Alejandro Osses

Figuration : Nicola Domenici, Angel Magnet

Crédits images expérimentales & Référents Scientifiques : Léo Varnet, Géraldine Carranante, Alejandro Osses

Ressources Scientifiques :

Varnet et al. 2019 – PMID: 31722636

Osses & Varnet 2024 – PMID: 38364046

Le projet est soutenu par : Agence Nationale de la Recherche & Audika

Tournage : École Normale Supérieure de Paris – France

Production : PSL-Qlife & Ça Fait Science

Remerciements : Mélissa Dewulf, Aïda Fakhr, Léa Wurges, Bruno Goud, Clementine Eyraud, Noëlle Aziz, École Normale Supérieure