Entretien publié sur le site de l’ENS Paris le 18/11/2020.

Léo Varnet est chargé de recherche CNRS au sein du laboratoire des systèmes perceptifs au département d’études cognitives de l’ENS-PSL. Le scientifique vient d’obtenir une bourse de recherche ANR pour poursuivre des travaux sur une méthodologie de psychologie expérimentale, initiés lors de sa thèse. Une ANR-fast ACI pour, en somme, accélérer le calcul des Images de Classifications Auditives (ACI) et ouvrir la voie, demain, à un paramétrage véritablement individualisé des audioprothèses.

Les Images de Classification Auditive : une nouvelle méthode pour visualiser nos représentations mentales des phonèmes

Comment notre cerveau fait-il pour différencier les phonèmes, les plus petites unités distinctives de la chaine parlée, de la langue ? Ou, dit autrement : qu’est-ce qui nous permet de décoder le son de parole que nous écoutons en une série de phonèmes ? Une problématique que Léo Varnet, aujourd’hui chargé de recherche CNRS au département d’études cognitives de l’ENS, explore avec enthousiasme depuis le début de sa thèse. « C’est une question de longue date en psycholinguistique. Elle peut sembler absurde au premier abord car la reconnaissance d’un phonème, ou même d’un mot, est réalisée extrêmement rapidement par le cerveau et la plupart du temps sans même que nous en ayons conscience. Pourtant les mécanismes cognitifs sous-jacents sont complexes et pour partie encore non élucidés. » explique le chercheur.

Pour aborder cette problématique, Léo Varnet a développé durant sa thèse une méthodologie de psychologie expérimentale : les Images de Classifications Auditives (ACI). L’obtention d’une bourse de recherche ANR cet automne lui permettra d’améliorer cette méthode, afin de mieux comprendre les mécanismes de reconnaissance des phonèmes et l’impact des pertes auditives sur la compréhension de la parole.

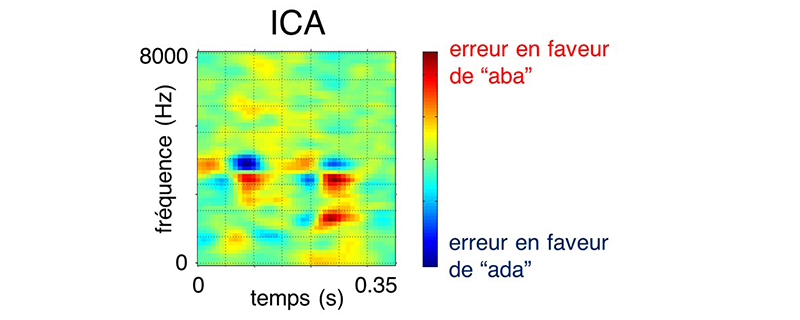

Léo Varnet et son équipe ont commencé par étudier la compréhension des phonèmes dans un bruit de fond, partant du principe que les erreurs commises par le cerveau dans des situations d’écoute difficiles peuvent nous informer sur les mécanismes qu’il utilise pour décoder les sons. C’est le principe même de l’Image de Classification Auditive.

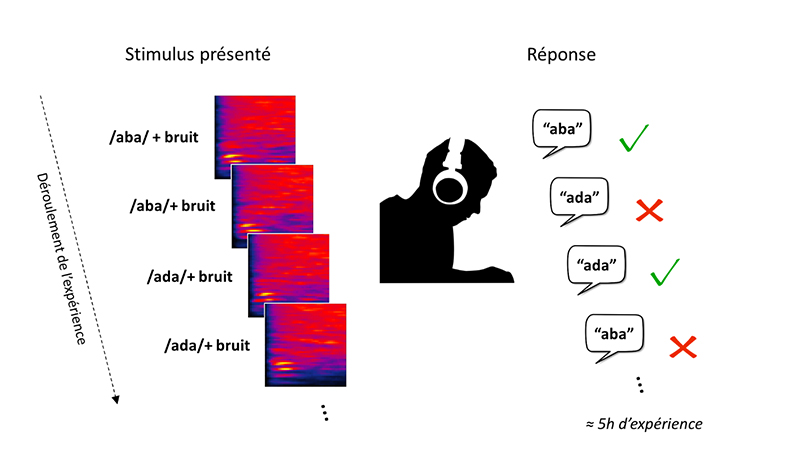

Plus précisément, les chercheurs ont recruté des volontaires à qui ils ont fait écouter une série de sons proches, des ‘aba’ ou des ‘ada’, dans un bruit de fond. Après chaque son, ils leur ont demandé d’indiquer s’il s’agissait d’un ‘aba’ ou d’un ‘ada’ . Puis avec un modèle statistique, Léo Varnet a analysé quelles étaient les particularités des bruits qui induisaient le plus en erreur les participants et participantes.

Les résultats apparaissent sous la forme d’une carte perceptuelle (d’où le nom d’ « image » de classification) qui représente les éléments du son sur lesquels nous portons notre attention, ici pour décider s’il s’agit d’un ‘aba’ ou d’un ‘ada’.

« Cette méthode nous permet d’observer les mécanismes très rapides qui se déroulent lors de la compréhension des phonèmes et, ce, sans utiliser d’électroencéphalogramme ou d’imagerie par résonance magnétique fonctionnelle qui sont plus contraignants, simplement en reliant les réponses ‘aba’ / ‘ada’ du participant ou de la participante aux bruits qui lui ont été présentés. » résume le scientifique.

« Naturellement, cette méthode n’est pas tombée du ciel, tient à préciser Léo Varnet. Elle s’inscrivait d’abord dans la ligne de recherche d’un projet ERC conduit par la psycholinguiste Fanny Meunier, et qui portait sur l’intelligibilité de la parole dans le bruit. Mais je me suis également largement inspiré de travaux dans le domaine de la perception visuelle, où des scientifiques avaient développé une approche très similaire. »

Après un important travail de développement, les chercheurs sont parvenus à transférer cette approche au domaine de l’audition et à l’appliquer à leur question, la perception des phonèmes. Puis, Léo Varnet a continué à développer plusieurs aspects de la méthodologie des images de classifications auditives, et l’a employée sur d’autres phonèmes (notamment le contraste /d/-/g/) et sur d’autres groupes d’auditeurs, en particuliers des musiciens.

Cette méthode offre un nouvel outil d’observation précieux pour l’exploration scientifique de la perception des phonèmes : « on peut comparer ça à l’invention d’un nouveau microscope : l’ACI nous permet de rendre visible certaines entités, ici des mécanismes perceptifs, dont on se doutait qu’elles étaient là mais sans pouvoir les examiner, et elle devrait donc grandement faciliter l’étude de ces mécanismes dans le futur. »

Cartographier la perception des phonèmes à l’aide d’algorithmes de machine learning

Mais ce nouveau mode d’exploration a un prix, la durée considérable de l’expérience. À l’heure actuelle, le calcul d’une ACI nécessite que le ou la participante passe un total de 5 heures environ dans la cabine expérimentale pour écouter des sons de parole bruités. Pour Léo Varnet, c’est évidemment un obstacle majeur à la généralisation de l’usage de cette technique. C’est pourquoi le premier enjeu de l’ANR fast-ACI consistera à accélérer le processus, en renforçant la méthode par des algorithmes de machine learning.

Une fois réalisés les développements méthodologiques évoqués ci-dessus, l’autre principal objectif de cette ANR sera de mettre en œuvre la méthode des ACI sur un maximum de phonèmes. Après le contraste /aba/-/ada/ précédemment étudié, il s’agira d’explorer /apa/-/ata/, /asa/-/aza/, /ubu/-/udu/…, de façon à couvrir la plus grande part de l’inventaire phonologique du français. Cette investigation systématique permettra aux chercheurs d’obtenir une cartographie de la perception des phonèmes par les personnes sans problème d’audition.

Sur la base de ces résultats, l’équipe de Léo Varnet explorera ensuite l’impact des pertes auditives sur les mécanismes de reconnaissance des phonèmes puis les capacités d’ajustement de ces processus en présence de différents bruits de fond.

Ces améliorations de la méthodologie d’Image de Classification Auditive seront primordiales pour la caractérisation et la remédiation des pertes auditives. « Cette technique permettant d’obtenir des résultats individuels très détaillés, il devrait donc être possible de l’utiliser à terme comme système diagnostic pour caractériser finement l’effet des pertes auditives sur la compréhension de la parole » détaille Léo Varnet. « De plus, une mesure objective de la stratégie d’écoute des personnes malentendantes, comme celle fournie par l’ACI, pourrait permettre d’obtenir un paramétrage véritablement individualisé des audioprothèses qui leur sont proposées. »

Etudier l’apprentissage des phonèmes chez les enfants

Et quid de la langue étudiée ? Les recherches se concentrent uniquement sur le français, car comme l’explique Léo Varnet le nombre de phonème varie d’une langue à l’autre (par exemple 37 pour le français, 44 pour l’anglais, 22 pour le japonais). Les contrastes phonétiques peuvent également différer entre les langues, par exemple les phonèmes [θ]-[ð] de l’anglais (respectivement dans ‘thing’ et ‘there’) sont difficiles à différencier pour les francophones car ils ne font pas partie de l’inventaire du français. « On s’attendrait donc naturellement, pour un contraste phonétique prédéfini, à observer des ACI différentes selon que les phonèmes appartiennent ou non à la langue des individus testés. Dans le cadre de cette ANR, nous nous restreindrons à l’étude des phonèmes du français, l’idée étant plutôt d’explorer la cohérence interne d’un système phonologique donné… Et même dans ce cas, il nous sera impossible d’être exhaustif, nous devrons faire des choix quant aux contrastes phonétiques que nous testerons. »

Une autre question que le scientifique souligne est celle de l’acquisition des phonèmes : comment le nourrisson apprend-il les catégories phonétiques de sa langue maternelle ? Comme dans le cas précédent des individus parlant des langues distinctes, les nouveaux-nés et les adultes perçoivent les mêmes phonèmes de façon différente. « C’est un phénomène qu’il devrait être possible de mettre en évidence au moyen de l’ACI. Il s’agit en fait d’un projet que je souhaite mettre en place à plus longue échéance : utiliser l’ACI pour étudier l’apprentissage des phonèmes chez les enfants durant la première année de leur vie. »

Des neurosciences à la psychophysique : observer l’esprit humain sans neuro-imagerie

L’obtention de cette ANR est une belle réussite pour Léo Varnet, passionné depuis toujours par la relation complexe entre le langage et le monde extérieur : « c’est très naturellement que je me suis dirigé vers la psycholinguistique, domaine à la frontière entre les sciences cognitives et la linguistique. Au tout début de ma thèse, j’avais en tête une approche très orientée neurosciences, c’est-à-dire schématiquement : utiliser des outils de neuro-imagerie comme l’EGG pour essayer de visualiser ce qui se passe dans le cerveau lorsque celui-ci écoute des sons de parole. Puis, au fur et à mesure de mes recherches, mes problématiques se sont précisées et je me suis intéressé de plus en plus à la psychophysique. »

Cette seconde approche consiste plutôt à s’intéresser au comportement d’individus engagés dans des tâches très simples, ici de compréhension de parole, comme révélateur des opérations qui se déroulent dans leur esprit… « J’ai été séduit par l’élégance de la démarche psychophysique à tel point que durant ma thèse, pourtant à l’origine une thèse en neurosciences, je n’ai finalement jamais employé de neuro-imagerie, et je me suis au contraire attelé à explorer le potentiel d’une technique purement comportementale. »

La rencontre avec le chercheur Christian Lorenzi a été également déterminante dans le développement dans les recherches de Léo Varnet, comme il l’explique : « son expertise en psychophysique, m’a incité à creuser encore davantage dans cette direction. Mais également, son approche de la psycholinguistique en lien étroit avec la perception. Comment nos capacités auditives contraignent notre compréhension du langage parlé ? Ceci m’a amené à considérer plus avant l’aspect auditif de mes recherches, notamment l’impact de la surdité sur la compréhension. »

Plus largement, Léo Varnet considère que la recherche ouvre une formidable possibilité de réflexion sur le temps long : « ce projet l’illustre bien puisque, je l’ai entamé il y a maintenant 8 ans avec ma thèse. Depuis, je n’ai pas arrêté de le revisiter, avec des périodes de développement et parfois de plus longues phases de maturation. Cette possibilité que nous avons dans les métiers de la recherche de tourner et retourner une problématique au gré des lectures et des collaborations, c’est quelque chose de précieux. »

Le chercheur, désormais en poste permanent, sait que « ce cheminement de la pensée suppose aussi une certaine stabilité matérielle ». Il est tout spécialement reconnaissant envers les personnes qui l’ont soutenu professionnellement : « j’ai eu la chance d’avoir un début de carrière sans véritable angoisse de la précarité. C’est aussi grâce à ces conditions professionnelles très favorables que ce projet a pu voir le jour. ».

| À propos de Léo Varnet

Léo Varnet est actuellement chargé de recherche CNRS au sein du laboratoire des systèmes perceptifs (LSP) au département d’études cognitives de l’ENS-PSL. Après une école d’ingénieur (Grenoble-INP), dont l’une de ses spécificités est d’entretenir de forts liens avec la recherche, il poursuit une thèse à Lyon, sous la co-supervision d’un neuroscientifique, Michel Hoen, et d’une psycholinguiste, Fanny Meunier. En sortie de thèse, il effectue une série de post-docs, d’abord à l’ENS-PSL sous la direction de Christian Lorenzi, un enseignant-chercheur travaillant sur la perception auditive, puis à l’University College of London, dans le département Speech Hearing and Phonetic Science. Il est ensuite recruté sur un poste de chercheur permanent au CNRS, basé à l’ENS-PSL. La perception au cœur de la recherche « L’objet d’étude central des chercheurs et chercheuses du LSP, c’est la perception : quels sont les mécanismes du traitement de l’information délivrée par les sens ? C’est-à-dire, plus simplement, comment est-ce que nous analysons les images ou les sons présents dans notre environnement ? Mais aussi : comment notre perception s’adapte en fonction du contexte, quelles sont les déficiences qui peuvent l’affecter, par exemple dans le cas des pertes auditives, ou encore comment nous parvenons à évaluer la fiabilité de nos propres perceptions. En pratique les recherches menées au LSP mettent l’accent sur deux sens particuliers, qui correspondent aux deux équipes de recherche du laboratoire : l’équipe Vision et l’équipe Audition. Au-delà de l’objet d’étude commun, la perception, l’autre aspect qui fait la cohésion du laboratoire, c’est une méthode d’investigation commune. Bien sûr, comme dans toutes les sciences cognitives, les chercheurs et chercheuses du LSP utilisent une large panoplie d’outils qui vont de la neurophysiologie à l’expérimentation comportementale, en passant par l’oculométrie et l’EEG. Mais derrière il y a presque toujours une démarche psychophysique, c’est-à-dire que nos investigations s’appuient essentiellement sur l’analyse des données collectées lors d’expériences perceptuelles très simples : dire si un bip est modulé ou non, dire si une image se déplace vers la droite ou vers la gauche, dire si un son est un ‘b’ ou un ‘d’, etc… » |