Dans un précédent billet, j’ai présenté le principe de la corrélation inverse, un outil mathématique permettant de caractériser le fonctionnement d’un système dont la mécanique exacte nous est inaccessible (représenté comme une « boîte noire » munie d’un câble électrique en entrée et d’un second câble en sortie). J’ai ensuite montré comment la même approche pouvait être appliquée à cette boîte noire particulière qu’est le cerveau humain. Une part de mon travail de recherche depuis ma thèse consiste à développer cette méthodologie dans le champ de l’étude de la perception des phonèmes par le système auditif.

Dans cet article, je décrirai le principe des Images de Classification Auditives (ICA) à travers l’exemple de la perception des sons « aba » et « ada ». Je laisserai momentanément de côté les considérations linguistiques – sur lesquelles je reviendrai dans un prochain article – pour me concentrer sur le positionnement du problème et la réponse apportée par les ICA.

Compréhension des phonèmes et indices acoustiques

Avant de pouvoir comprendre un son de parole qui nous parvient, notre cerveau doit en premier lieu identifier les phonèmes qui le composent. Lors de la communication parlée, ce processus s’effectue de manière inconsciente et extrêmement rapide ; néanmoins, cette simplicité apparente masque une série de mécanismes complexes et encore en grande partie non élucidés. C’est à ce « décodage » des sons en unités linguistiques par le système auditif que je m’intéresse ici et, en particulier, aux mécanismes à l’œuvre à l’interface entre acoustique et phonétique, c’est-à-dire entre les caractéristiques du son physique brut et le travail de reconnaissance opéré par le système auditif.

Étant donné que nous sommes capables de reconnaître les phonèmes prononcés par notre interlocuteur ou interlocutrice, même par la seule voie auditive (par exemple lors d’une communication téléphonique ou à la radio), il est certain que l’information relative à l’identité des phonèmes est entièrement contenue dans le son de parole1. Autrement dit, notre système auditif est en mesure de repérer et d’extraire certaines caractéristiques acoustiques particulières du son de parole puis de les combiner pour identifier de manière univoque les phonèmes qui composent ce son. Les caractéristiques acoustiques en question, appelées « indices acoustiques », correspondent à des éléments transitoires du signal sonore, comme par exemple le silence très bref qui accompagne la production d’une consonne plosive (/b/, /d/, /g/, /p/, /t/, /k/). Ces indices acoustiques sous-tendent la compréhension des phonèmes par le cerveau humain et constituent en quelque sorte les « éléments de base » assurant l’interface entre acoustique et linguistique dans la communication parlée.

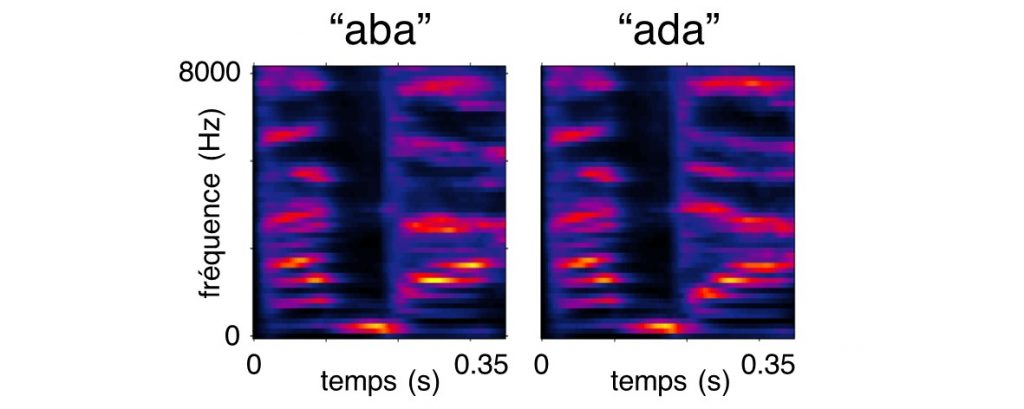

Depuis bientôt un siècle, l’identification des indices acoustiques de la parole est l’une des problématiques récurrentes de la psycholinguistique. Une analyse acoustique montre que cette question n’est pas triviale. Par exemple : comment notre système auditif parvient-il à identifier les deux syllabes suivantes ?

Autrement dit : quelles sont les caractéristiques acoustiques qui nous permettent de catégoriser ces deux sons respectivement comme un /aba/ et un /ada/ ? Pour le savoir, nous pouvons, en premier lieu, examiner le contenu acoustique de ces deux enregistrements :

On constate ainsi que le contraste phonétique /b/-/d/ se traduit par de multiples différences acoustiques visibles dans les enregistrements de /aba/ et /ada/. Autrement dit, l’information contenue dans le signal de parole est redondante, le changement d’un seul phonème étant encodé par plusieurs changements dans le son. Ceci nous amène donc à reformuler la question précédente : parmi toutes ces différences, quelles sont celles effectivement utilisées par le système auditif pour reconnaître ces deux sons ? Sur quelles portions du signal sonore portons-nous notre attention lorsque nous cherchons à différencier un /b/ d’un /d/ ? Pour aller plus loin, il est nécessaire de compléter cette description purement acoustique des phonèmes par des expérimentations en perception de la parole.

L’Image de Classification Auditive

C’est ici que l’Image de Classification Auditive (ICA) entre en jeu. Il s’agit d’une méthode expérimentale que j’ai mise au point durant ma thèse, avec l’appui de Michel Hoen, Fanny Meunier et Kenneth Knoblauch [1, 2, 3]. Fondamentalement, elle consiste à mettre en difficulté le système auditif en lui présentant des sons de parole fortement bruités, et à examiner les erreurs qu’il commet de façon systématique et récurrente, qui sont le reflet des traitements qu’il effectue.

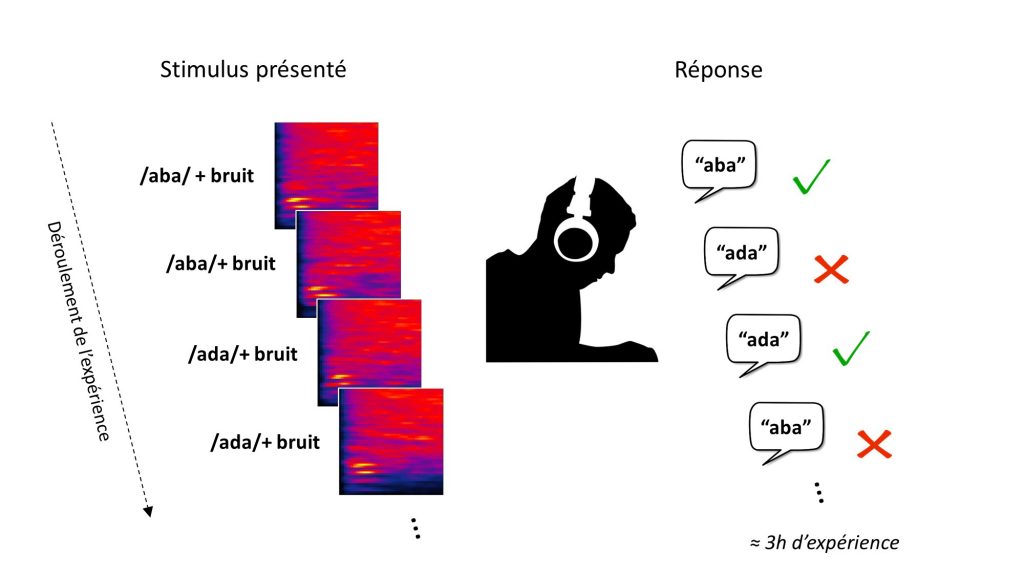

La première expérience que j’ai réalisée avec la méthode des ICA [2] portait sur les enregistrements de « aba » et « ada » présentés plus haut. Les participantes et participants recrutés avaient pour consigne de différencier ces deux sons malgré un important bruit de fond. Voici, à titre d’exemple, une portion de l’expérience :

La tâche demandée consistait, après chaque stimulus, à indiquer si l’on pensait avoir entendu « aba » ou « ada », en appuyant sur la touche correspondante du clavier. L’expérience avait une durée totale de 3 heures environ, et était entrecoupée de pauses régulières.

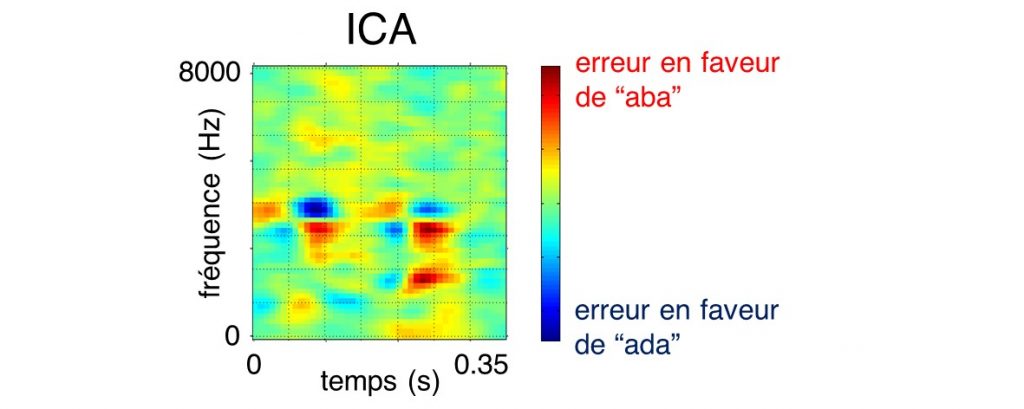

Comme l’exemple audio ci-dessus le laisse deviner, la discrimination du /b/ et du /d/ dans un tel niveau de bruit conduit à de nombreuses confusions (réponse « aba » alors que « ada » était présenté ou inversement). Pour connaître les caractéristiques précises des stimuli qui sous-tendent le choix d’une réponse ou d’une autre nous avons, pour chaque essai, relié le contenu acoustique du bruit à la décision phonétique qu’il engendre – une analyse extrêmement similaire à celle de l’expérience d’Ahumada décrite dans le billet précédent. Cette corrélation2 entre le stimulus physique (le son) et la réponse comportementale (la décision « aba » ou « ada ») aboutit à une carte indiquant les régions du spectre sonore dans lesquelles la présence de bruit induit en erreur le système auditif :

L’ICA obtenue à l’issue de cette expérience montre que les régions temps-fréquence où le bruit brouille effectivement la décision phonétique aba/ada – les zones en rouge et en bleu sur la figure – sont en fait extrêmement localisées, d’une durée d’environ 50 millisecondes soit 5 centièmes de seconde ! Elles correspondent aux éléments du son essentiels à sa compréhension (lorsque ces derniers sont masqués par le bruit, l’intelligibilité est systématiquement compromise), c’est-à-dire aux indices acoustiques dont l’existence a été postulée dans la première partie de cet article.

Ce résultat offre ainsi la démonstration directe de la réalité perceptuelle des indices acoustiques. Qui plus est, la méthode des ICA permet de visualiser et de caractériser ces indices, et ainsi de répondre à la question que nous nous posions : quelles sont les informations acoustiques contenues dans le phonème qui sont déterminantes pour sa compréhension par le cerveau humain ? Dans le cas de la catégorisation aba/ada, on constate notamment que plusieurs indices acoustiques concourent à l’identification du phonème (nombreuses taches rouges et bleues sur l’ICA).

Le principe de base de l’approche décrite ici repose sur l’étude des erreurs du système auditif, qui nous renseignent sur son fonctionnement général. Nous avons tiré parti de la situation de compréhension de parole dans un environnement bruité pour mettre en évidence la systématicité de certaines confusions et en tirer des conclusions sur les mécanismes cognitifs sous-jacents3. Ce type de raisonnement est extrêmement répandu dans de nombreux domaines des sciences cognitives. Ainsi, par exemple, c’est de l’étude de la récurrence de certaines erreurs typiques chez les enfants que Piaget parvint à des conclusions concernant les stades du développement cognitifs, notamment la conservation de la substance. De même, c’est l’observation du fait que certaines fautes de syntaxe sont plus fréquentes que d’autres qui amena Chomsky à formuler des hypothèses concernant le traitement du langage. Enfin, la psychophysique s’intéresse de près aux illusions auditives ou visuelles et aux cas limites de la perception, qui permettent d’enrichir notre compréhension des mécanismes à l’œuvre à l’interface entre acoustique et perception [4].

À ce stade, plusieurs questions restent ouvertes. Du point de vue de la psycholinguistique, on peut se demander à quelles propriétés phonétiques correspondent les indices acoustiques observés sur l’ICA, s’ils se généralisent à d’autres contrastes (par exemple ibi/idi), ou quelles sont les règles qui régissent leur intégration en un percept phonémique unique. Plus philosophiquement, ces résultats conduisent à s’interroger sur la nature notre observation : s’agit-il véritablement d’une visualisation directe de la représentation mentale des phonèmes dans le cerveau humain ? Pourrait-on s’appuyer sur l’ICA pour tracer les contours d’une nouvelle définition du concept de phonème ? J’aborderai ces questions dans de prochains articles.

Références

[1] L. Varnet, « Identification des indices acoustiques utilisés lors de la compréhension de la parole dégradée », Thèse, Université Claude Bernard – Lyon I, Lyon, France, 2015.

[2] L. Varnet, K. Knoblauch, F. Meunier, et M. Hoen, « Using auditory classification images for the identification of fine acoustic cues used in speech perception. », Front. Hum. Neurosci., vol. 7:, p. 865, 2013.

[3] L. Varnet, K. Knoblauch, W. Serniclaes, F. Meunier, et M. Hoen, « A Psychophysical Imaging Method Evidencing Auditory Cue Extraction during Speech Perception: A Group Analysis of Auditory Classification Images », PLoS ONE, vol. 10, no 3, p. e0118009, mars 2015.

[4] D. Pressnitzer, C. Suied, et S. A. Shamma, « Auditory scene analysis: the sweet music of ambiguity », Front Hum Neurosci, vol. 5, p. 158, 2011.

1 Même si l’ajout d’une autre modalité (par exemple visuelle) peut grandement faciliter la communication, en particulier dans un environnement bruyant, l’information auditive est en principe suffisante.

2 En réalité il ne s’agit pas ici d’une corrélation mais d’un modèle statistique plus complexe et mieux adapté à la description de cette tâche perceptuelle. Pour plus de détails concernant le cadre mathématique de ces recherches, consulter les références [1], [2] et [3].

3 Réciproquement, il est possible d’utiliser l’ACI pour manipuler la perception et induire en erreur l’auditeur ou l’auditrice, comme décrit dans un autre article.

Une réflexion sur « L’Image de Classification Auditive, partie 2 : À la recherche des indices acoustiques de la parole »